Richtigkeit, Genauigkeit und Präzision

Warum macht es eigentlich Sinn, „Genauigkeit“ und „Präzision“ im Zuge von Methodenvalidierungen zu bestimmen? Was steckt dahinter? Und wie stehen die Begriffe „Richtigkeit“, „Genauigkeit“ und „Präzision“ miteinander in Verbindung?

Gemäß der Methodenvalidierungsguideline ICH Q2(R1) sind im Zuge von Methodenvalidierungen nur Genauigkeit (accuracy) und Präzision (precision) zu bestimmen. Sie sind in der ICH Q2(R1) wie folgt definiert [1]:

“The precision of an analytical procedure expresses the closeness of agreement (degree of scatter) between a series of measurements obtained from multiple sampling of the same homogeneous sample under the prescribed conditions. Precision may be considered at three levels: repeatability, intermediate precision and reproducibility.”

“The accuracy of an analytical procedure expresses the closeness of agreement between the value which is accepted either as a conventional true value or an accepted reference value and the value found. This is sometimes termed trueness.”

Und genau da liegt ein Schwachpunkt: accuracy (Genauigkeit) und trueness (Richtigkeit) sind gemäß ISO 5725-1 [2] nicht das gleiche, werden aber ziemlich leicht durcheinandergebracht oder in einen Topf geworfen. Bevor wir dem aber auf den Grund gehen, ist die Frage nach dem Sinn solcher Bestimmungen einfacher zu beantworten. Alle Messungen, die durchgeführt werden, sind von Messfehlern begleitet, wobei zwischen zufälligen und systematischen Fehlern unterschieden wird (siehe auch unser Blogbeitrag dazu). Und die Bestimmungen der Genauigkeit bzw. eigentlich der Richtigkeit und der Präzision offenbaren genau solche Fehler, wie wir im Folgenden sehen werden.

Richtigkeit (trueness)

Mit Richtigkeit wird eigentlich das ausgedrückt, was die ICH Q2(R1) für accuracy aussagt, nämlich das Maß an Übereinstimmung zwischen dem Mittelwert eines Datensatzes und dem „wahren Wert“ (SOLL-IST-Vergleich). Da jedoch der wahre Wert nur theoretischer Natur ist und man ihn nie bestimmen kann, wird stattdessen ein als richtig angesehener, anerkannter Referenzwert verwendet (welcher selber natürlich auch mit einer gewissen Unsicherheit behaftet ist). Entsprechend ist die Definition der Richtigkeit gemäß ISO 5725-1 wie folgt:

“The closeness of agreement between the average value obtained from a large series of test results and an accepted reference value.”

Mathematisch ausgedrückt können wir auch sagen, dass die Richtigkeit den Betrag der Differenz aus Mittelwert x und Referenzwert xRef abbildet: Richtigkeit = |x − xRef|

Wir hören also daraus, dass die Richtigkeit etwas über die Lage des Mittelwerts aussagt, daher wird die Richtigkeit im Englischen außer als trueness auch als accuracy of the mean bezeichnet, was es meiner Meinung nach sehr gut trifft, von dessen Verwendung die ISO 5725-1 jedoch abrät.

Um jetzt den Abstand des Mittelwerts zum Referenzwert auszudrücken, wird für die Angabe der Richtigkeit der prozentuale Fehler (%error) oder die Wiederfindungsrate (recovery) verwendet, da sie die beiden Größen (Mittelwert und Referenzwert) zueinander in Beziehung bringt.

Die Richtigkeit wird durch systematische Fehler (bias) beeinflusst. Ein „wahres“ Ergebnis, also eine hohe Richtigkeit, hat man, wenn der Mittelwert der Messungen gut mit dem erwarteten Referenzwert übereinstimmt. Das bedeutet, dass keine bzw. nur kleine systematische Fehler vorliegen. Es sagt jedoch nichts über die Verteilung der der einzelnen Messwerte, also ihre Streuung aus. Dies wird durch die Präzision ausgedrückt, aber dazu später mehr.

Bildlich gesprochen, ist eine hohe Richtigkeit gegeben, wenn ein Fußballspieler generell ins Tor trifft ohne Rücksicht darauf, ob es in die obere linke oder die untere rechte Ecke ist. Entsprechend liegt eine geringe Richtigkeit vor, wenn die meisten Schüsse danebenliegen. Interessant wird es, wenn unser Spieler beispielsweise jeden einzelnen Schuss an der rechten Seite des Tors vorbeischießt… Wir sprechen mit ihm und stellen fest, dass er leider eine leichte Krümmung im Bein hat. Das ist ein gutes Beispiel für einen systematischen Fehler: das verkrümmte Bein bewirkt (analog einem schlecht kalibrierten Messgerät), dass alle Schüsse (Ergebnisse) in die gleiche Richtung verschoben sind. Damit wird auch deutlich, dass die Richtigkeit nicht mit zusätzlichen Messungen verbessert werden kann (der zu Grunde liegende systematische Fehler würde die zusätzlichen Messungen genauso verschieben).

Präzision

Wie wir oben bereits angedeutet haben, ist die Präzision ein Streumaß und gibt Aussage über das Maß an Übereinstimmung einzelner unabhängiger Messwerte eines Datensatzes voneinander. Sie ist ein Charakteristikum eines Datensatzes und kennzeichnet die Streuung der Messwerte um den Mittelwert. [Anm. d. Red.: Das bedeutet logischerweise, dass eine einzelne Messung nicht „präzise“ sein kann – wenn man Wortklauberei betreiben möchte…] Dementsprechend kann sie durch die (relative) Standardabweichung ausgedrückt werden. Aber auch ein kleiner Wertebereich, ein schmales Konfidenzinterval oder ein geringer Abstand zwischen Quartilen in einem Boxplot veranschaulichen eine hohe Präzision.

Und was verursacht die Streuung der Messwerte? Zufällige Fehler!

Im Unterschied zur Richtigkeit wird bei der Präzision nur der Datensatz an sich betrachtet, unabhängig von einem „externen“ Bezugswert. Es wird also keine Aussage darüber getroffen, wie weit die Messwerte vom wahren Wert entfernt sind. Daher kann ein Datensatz zwar eine hohe Präzision aufweisen (alle Werte liegen nah beieinander, weisen also nur eine sehr kleine Streuung auf), aber vollkommen falsch sein. Das ist der Fall, wenn unser Fußballspieler mit dem verkrümmten Bein mit jedem Schuss das Tor nur ganz knapp verfehlt. Damit ist er zwar sehr präzise, da der Ball immer an fast derselben Stelle landet, aber leider falsch, da das Tor ja nicht getroffen wird… Die zu Grunde liegenden zufälligen Fehler beeinflussen dann die exakte Lage des Balls neben dem Tor. Das kann einmal eine ganz leicht angehobene Fußspitze oder ein andermal eine Windböe sein…

Wenn wir die Beinverkrümmung (= Bias) jetzt mal außen vorlassen und an einen gesunden Spieler denken, wird verständlich, dass die Präzision durchaus mit zusätzlichen Messungen verbessert und entsprechend die Messunsicherheit verringert werden kann. Mehr Schüsse erhöhen die Wahrscheinlichkeit überhaupt ins Tor zu treffen ;-)

Den Hintergrund obiger Erläuterungen bildet auch hier die Definition in der ISO 5725-1 sowie die dazugehörigen Anmerkungen: „The closeness of agreement between independent test results obtained under stipulated conditions.

Note 1 to entry: Precision depends only on the distribution of random errors and does not relate to the true value or the specified value.

Note 2 to entry: The measure of precision is usually expressed in terms of imprecision and computed as a standard deviation of the test results. Less precision is reflected by a larger standard deviation.

Note 3 to entry: "Independent test results" means results obtained in a manner not influenced by any previous result on the same or similar test object. Quantitative measures of precision depend critically on the stipulated conditions. Repeatability and reproducibility conditions are particular sets of extreme conditions.”

Wenn auch jeweils anders ausgedrückt, unterscheidet sich hier die Bedeutung der Präzision zwischen der ICH Q2(R1) und der ISO 5725-1 nicht.

Genauigkeit (accuracy)

Im Gegensatz zur Präzision spielt bei der Genauigkeit der Bezug zum wahren Wert wieder eine Rolle, da die Genauigkeit definiert ist als das Maß der Übereinstimmung zwischen einem einzelnen Messwert und dem wahren Wert bzw. dem Referenzwert. Es handelt sich also wieder um einen SOLL-IST-Vergleich. Hm, das kommt einem doch irgendwie bekannt vor… Die Richtigkeit war doch so ähnlich, oder? Der Unterschied zur Richtigkeit liegt darin, dass bei der Richtigkeit der Mittelwert des Datensatzes und hier nur ein Einzelwert in Bezug zum Referenzwert gesetzt wird. Zudem unterscheidet sich die Berechnung, da die Genauigkeit mathematisch gesprochen als das Verhältnis aus der Differenz von Messwert xi und Referenzwert xRef zum Messwert definiert wird: Genauigkeit=|xi−xRef| / xi

Die Genauigkeit wird durch beide Fehlerarten (zufällige und systematische Fehler) beeinflusst. Entsprechend kann man auch sagen, dass sie ausdrückt, wie gut Richtigkeit und Präzision in Einklang stehen und daher als Oberbegriff anzusehen ist. Man erzielt eine hohe Genauigkeit nur, wenn sowohl die Richtigkeit als auch die Präzision gut sind.

Die ISO 5725-1 definiert die Genauigkeit wie folgt: “The closeness of agreement between a test result and the accepted reference value.” und macht dabei noch folgende Anmerkung: “Note 1 to entry: The term accuracy, when applied to a set of test results, involves a combination of random components and a common systematic error or bias component.”

Abgrenzung, Zusammenhänge und zugrunde liegende Fehlerarten

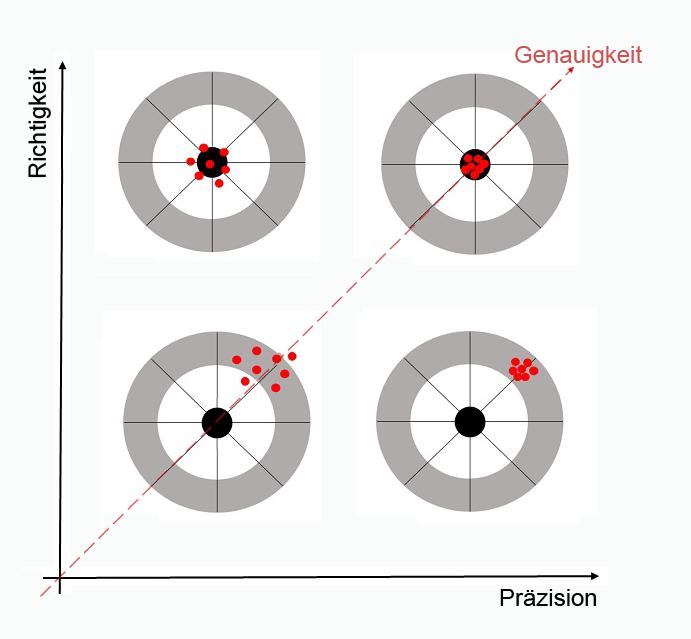

Zusammengefasst kann man festhalten, dass die 3 Begriffe Richtigkeit, Präzision und Genauigkeit zwar einerseits von ihren Definitionen her voneinander abzugrenzen sind, aber andererseits trotzdem auch Gemeinsamkeiten aufweisen und zueinander in Beziehung stehen, was in nachfolgender Tabelle und Abbildung veranschaulicht wird:

| Richtigkeit | Präzision | Genauigkeit | |

| englisch | trueness, accuracy of the mean | precision | accuracy |

| Aussage | Abstand des Mittelwerts vom Referenzwert | Streuung von Einzelwerten um den Mittelwert | Abstand eines Einzelwerts vom Referenzwert |

| - | Lageparameter | Streuparameter | beides |

| - | Datensatz | Datensatz | Einzelwert |

| Fehlerart | Systematische Fehler | Zufällige Fehler | beide |

| Kenngröße | Mittelwert | Standardabweichung | - |

Die Zusammenhänge dieser drei Begriffe und der zugrundeliegenden Fehlerarten lassen sich mit Hilfe eines schönen Bildes (in Anlehnung an [3]) veranschaulichen.

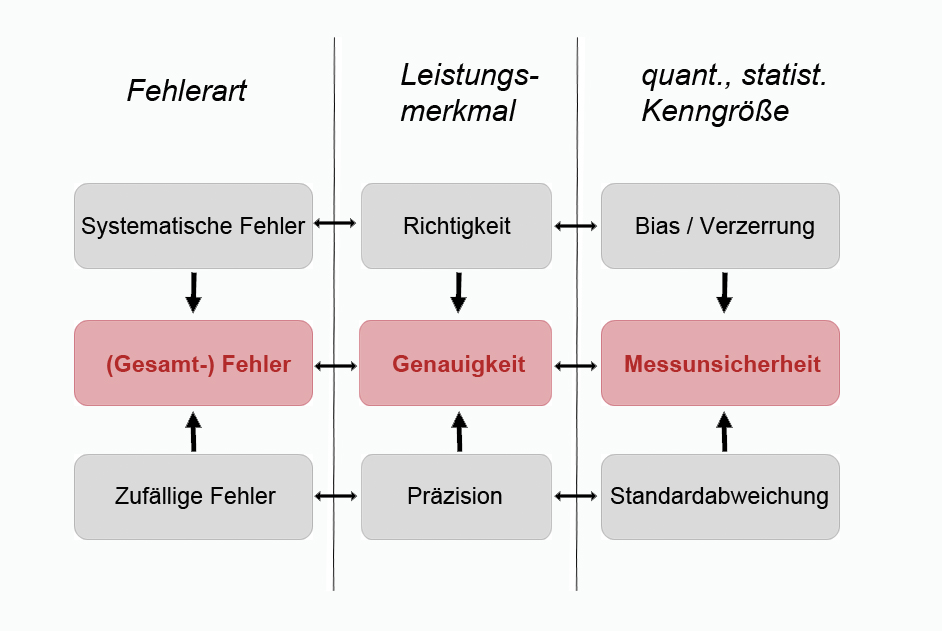

Die Abbildung veranschaulicht die Beziehung der Begrifflichkeiten der dem Leistungsmerkmal (Richtigkeit, Genauigkeit, Präzision) der Methode zu Grunde liegenden Fehlerart (zufälliger, systematischer oder Gesamtfehler) sowie dessen quantitative statistischen Kenngrößen (Bias, Messunsicherheit, Standardabweichung).

Jeder Messung liegt ein Gesamtfehler zu Grunde, der sich aus zufälligen und systematischen Fehlern zusammensetzt. Da diese Fehler nie komplett erfasst werden können, muss man mit Schätzungen dieser Fehler arbeiten, die durch die Leistungsmerkmale der Methode evaluiert werden. Dabei zielt die Richtigkeit auf den systematischen und die Präzision auf den zufälligen Fehler ab, während die Genauigkeit beides umfasst. Quantitativ ausgedrückt werden die Leistungsmerkmale mit den statistischen Kenngrößen Bias (oder auch Verzerrung genannt), Standardabweichung und Messunsicherheit.

Schlussbemerkung am Rande

In diesem Blogbeitrag sind wir bewusst nicht auch noch zusätzlich auf die Definitionen von Richtigkeit, Präzision und Genauigkeit des JCGM [4] eingegangen. Dem geneigten Leser sei aber gesagt, dass die Definitionen für Präzision und Genauigkeit von der Bedeutung her in etwa mit den hier dargestellten übereinstimmen, die der Richtigkeit jedoch einen leicht anderen Aspekt enthält.

Referenzen

[1] ICH Q2(R1) (2005). Validation of Analytical Procedures: Text and Methodology

[2] ISO 5725-1 (1994). Accuracy (trueness and precision) of measurement methods and results – Part 1: General principles and definitions

[3] Menditto A., Patriarca M., Magnusson, B. (2006). Understanding the meaning of accuracy, trueness and precision, Accred Qual Assur, Vol. 12:45–47

[4] Joint Committee for Guides in Metrology (2012). International vocabulary of metrology – Basic and general concepts and associated terms (VIM), JCGM 200:2012